Depuis le déploiement de l’algorithme 360Brew de LinkedIn, de nombreuses utilisatrices témoignent d’une chute brutale de leur visibilité sans aucun changement notable dans leur contenu ou leur cadence de publication. Des expérimentations montrent que des profils passent nettement devant après avoir modifié leur genre déclaré ou leur style d’écriture . Cela soulève une question majeure : l’algorithme favorise-t-il les hommes, instaure-t-il malgré lui un biais de genre structurel dans la portée des publications ? Cet article analyse les données, les témoignages, et les mécanismes techniques de biais algorithmique pour comprendre comment une plateforme professionnelle peut, sans volonté explicite, amplifier des inégalités invisibles… mais bien réelles.

Ces dernières semaines, sur LinkedIn, j’observe une série de signaux faibles qui, mis bout à bout, commencent à former un faisceau plus que troublant…

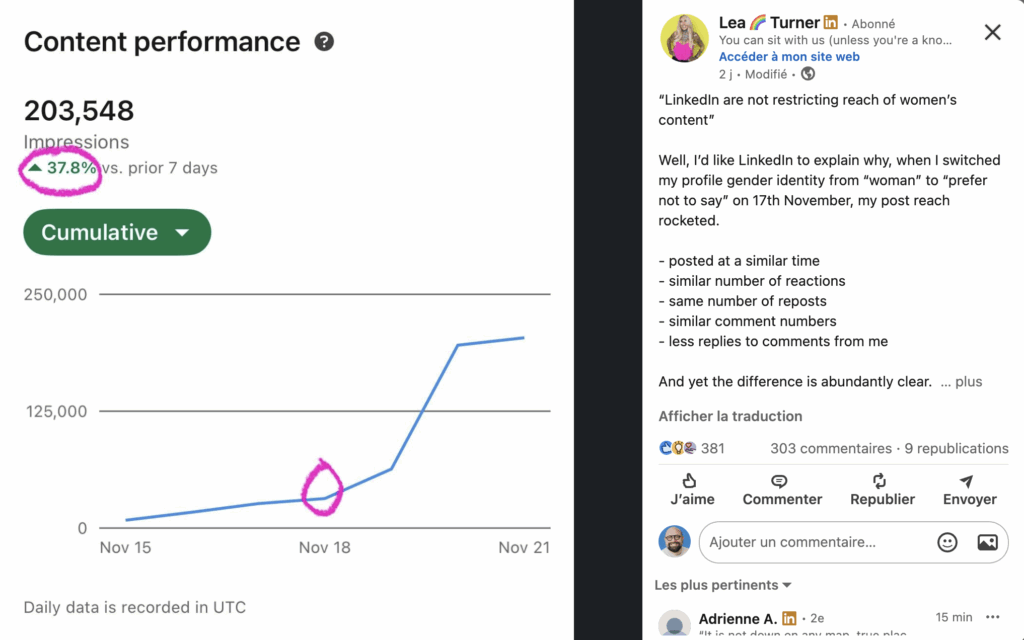

Depuis l’entrée en vigueur du modèle 360Brew, le nouveau moteur de recommandation fondé sur l’IA de LinkedIn, de nombreuses créatrices de contenu rapportent une chute soudaine et parfois spectaculaire de leur portée, qu’elles mettent en lien avec leur genre.

Certaines parlent d’une division par 10, voire 20, de leurs impressions. D’autres voient leur visibilité s’effondrer du jour au lendemain, sans changement dans leur contenu ni dans leur fréquence de publication.

Lorsque Megan Cornish, qui a été l’une des premières à formaliser un protocole expérimental, a décidé de modifier son genre déclaré sur LinkedIn et de réécrire son profil dans un style plus “masculin”, sa visibilité a grimpé de 400% en une semaine. Et de raconter cette expérience dans un post devenu viral, puis dans un long texte publié sur Substack (“LinkedIn Likes Me Better as a Man”).

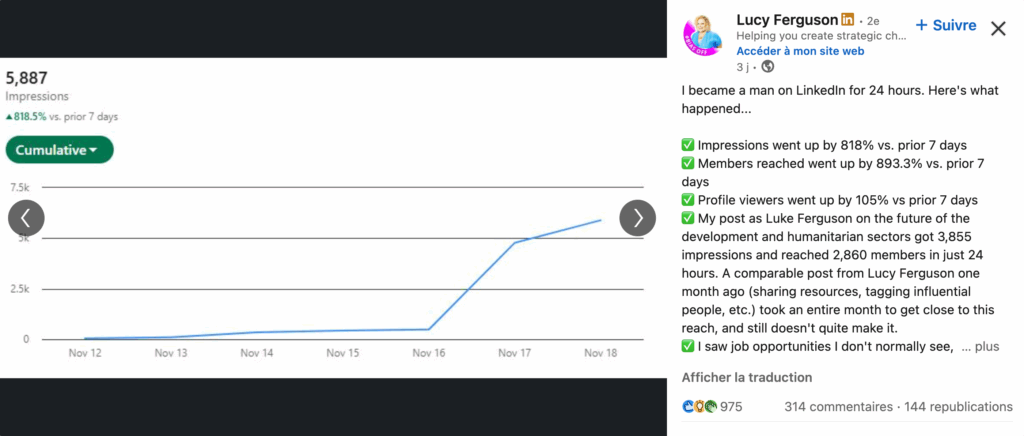

Quand Lucy Ferguson est devenue “Luke” pour vingt-quatre heures ? Ses impressions ont augmenté de 818%, et les membres atteints de près de 900%.

Malin Frithiofsson, Jane Evans, Cindy Gallop et Jane Evans, Bo Young Lee, Dorothy Dalton, Felicity Menzies… et des centaines d’autres témoignages, venus des États-Unis, d’Australie, d’Allemagne, de Belgique ou de France ont décrit le même scénario, avec ou sans le hashtag #wearthepants.

Des femmes changent un « simple » paramètre dans leurs réglages LinkedIn, leur genre déclaré, et voient, en quelques jours, la portée de leurs publications exploser.

Alix Willemez a résumé son étude et toutes les autres à sa façon : « I’m officially a man. (…) And just like that: more reach, more impressions, more engagement. »

Un décalage inédit entre audience réelle et distribution algorithmique

À ce stade, j’ai sollicité l’avis et les témoignages de mes followers, et j’ai parcouru une dizaine de cas. Certains relèvent de la pure anecdote, d’autres s’appuient sur des protocoles plus rigoureux.

L’expérience de Felicity Menzies est, à mon sens, la plus éclairante. Elle n’a changé ni son genre, ni son visage, ni sa photo. Elle n’a pas réinventé pas son identité numérique.

Elle a publié trois articles identiques, rédigés chacun dans un style différent :

- un style neutre

- un style « masculin » codé (plus assertif, plus directif…)

- un style « féminin » codé (plus relationnel, plus collaboratif…)

Puis elle a envoyé les trois publications simultanément à son audience newsletter — plus de 17.000 abonnés.

Cela lui a permis de dissocier deux choses :

- L’intérêt réel du public (mesuré via les lectures de newsletter)

- La distribution algorithmique sur LinkedIn (mesurée via les impressions)

Résultats ?

● Le style masculin est le plus amplifié par LinkedIn

● Le style neutre est le plus lu par l’audience réelle

● Le style féminin est systématiquement le moins visible sur la plateforme

Autrement dit : l’algorithme récompense davantage un certain type de voix… Mais ce n’est pas nécessairement celle que les lecteurs préfèrent.

Et c’est là que le problème commence.

Un algorithme qui n’utilise pas le genre… mais qui valorise les traces qu’il laisse

LinkedIn affirme ne pas utiliser le genre pour classer les contenus. Je veux bien le croire. Personne, en 2025, n’ajouterait volontairement « if(female)then downrank« .

Mais le biais algorithmique, aussi appelé biais « par proxy », lui, ne demande aucune intention. Il émerge spontanément dès qu’un modèle apprend sur :

- des comportements humains biaisés

- des historiques d’interaction biaisés

- des normes professionnelles biaisées

- des signaux linguistiques codés

- des schémas d’autorité hérités du monde du travail

Or c’est exactement ce que fait 360Brew. C’est un modèle de langage géant (150 milliards de paramètres) qui prédit la probabilité qu’un poste génère un commentaire, un “voir plus”, un partage privé, un enregistrement…

Au moins 3 biais

Dans ses recherches sur le sujet, Martyn Redstone, a identifié trois proxys probables de ce biais :

- Le biais lié aux thématiques : l’algorithme peut avoir été entraîné à favoriser les sujets considérés comme “durs” (par exemple la tech, la finance, le sales..) au détriment des sujets jugés plus “soft” (comme la diversité, l’équité et l’inclusion, la culture de travail, le harcèlement ou l’épuisement professionnel) qui, bien que cruciaux, sont davantage abordés par des femmes

- Le biais lié au langage : la recherche montre que le langage professionnel est fortement genré. Les hommes sont souvent décrits avec des termes “agentiques” (“ambitieux”, “stratégique”, “leader”…), tandis que les femmes le sont avec des termes “communautaires” (“collaborative”, “bienveillante”, “aidante”…). Si l’algorithme a appris qu’un langage “agentique” équivaut à de l’autorité, il va mécaniquement sous-classer les contenus écrits dans un style plus “communautaire”.

- Le biais lié aux données : l’algorithme peut pénaliser les trajectoires professionnelles qui ne correspondent pas au modèle traditionnel et linéaire. Cela inclut notamment les pauses de carrière, prises beaucoup plus fréquemment par des femmes, souvent pour des responsabilités de caregiving.

Amplification des biais

Et que se passe-t-il, à votre avis, quand on optimise un modèle biaisé, uniquement pour maximiser l’engagement ? Il renforce mécaniquement ce qui, historiquement, génère le plus d’engagement rapide :

- l’assertivité

- les prises de position tranchées

- les déclarations fortes

- le langage agentique

- les tonalités à haute charge émotionnelle

Or ce registre est… sociologiquement masculin.

Ce n’est donc pas un biais de genre direct. C’est bien pire : c’est un biais structurel, enraciné dans le fonctionnement même du modèle.

Quand les créatrices adaptent leur comportement… et que l’algorithme interprète cela comme un manque d’intérêt

Ce que beaucoup d’analyses techniques omettent de mentionner, c’est la dimension sociale.

Je suis un homme. Sur LinkedIn, je n’ai jamais reçu d’avances romantiques ou de messages à caractère sexuel… contrairement à 91% des femmes actives sur ce réseau social professionnel.

Comme sur toutes les plateformes, les femmes doivent gérer sur LinkedIn une couche supplémentaire de « frictions » invisibles :

- sollicitations ambiguës

- messages privés insistants

- commentaires déplacés

- micro-agressions

- surveillance de leur image

- obligation de modérer leur visibilité par prudence

Beaucoup finissent par :

- limiter leurs publications

- restreindre la visibilité de leur réseau

- éviter certains sujets

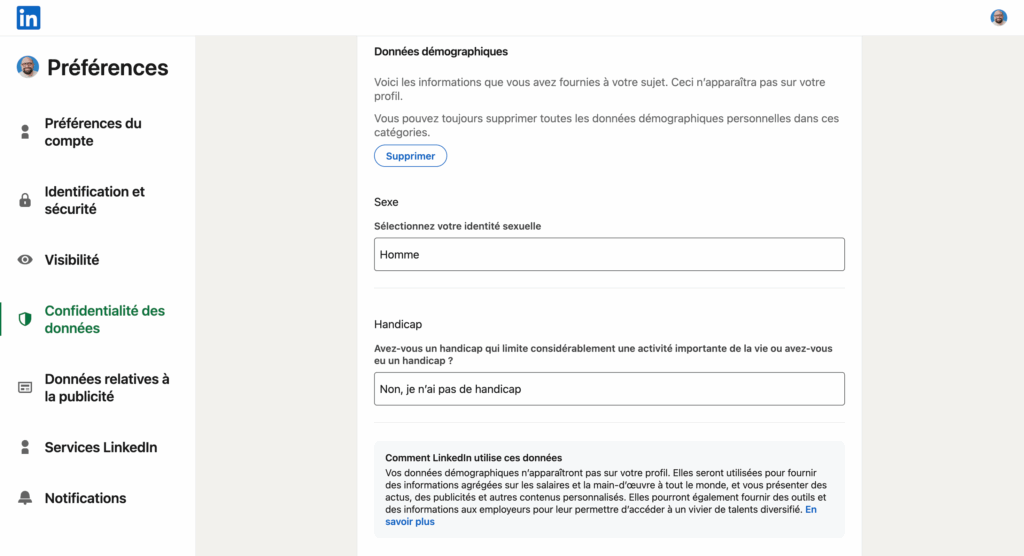

- désactiver leurs données démographiques

- poster moins souvent pour “avoir la paix”

Or du point de vue de 360Brew, ces comportements sont interprétés comme :

moins d’activité = moins d’intérêt = moins de pertinence = moins de portée.

Le modèle punit la protection. Et ce qui, pour une utilisatrice, relève du bon sens ou de la sécurité numérique, devient pour l’IA une source de “downrank” statistique.

Nous sommes ici face à ce que des chercheuses en algorithmique appellent une « double peine ». Le MIT l’a déjà montrée pour la mise en relation candidats-offres sur LinkedIn, Safiya Umoja Noble pour les moteurs de recherche, Joy Buolamwini et Timnit Gebru pour la reconnaissance faciale…

La plateforme qui “reflète” son propre passé

Les algorithmes ne créent pas la double peine, mais ils la codent et la mettent à l’échelle.

Or, dans le monde professionnel, et sur LinkedIn (où 44% des membres sont des femmes), historiquement :

- les hommes publient davantage sur des sujets techniques

- les hommes reçoivent davantage de commentaires mixtes

- les hommes sont identifiés comme “experts” plus facilement

- les femmes sont davantage valorisées sur des contenus relationnels

- les tonalités masculines sont perçues comme plus “crédibles”

Une étude d’Into The Minds sortie il y a trois ans montrait même que les femmes reçoivent beaucoup plus d’engagement brut, mais moins d’autorité perçue.

Lorsque 360Brew lit ces traces, il ne lit pas seulement le contenu : il lit la culture qui s’y imprime.

Et c’est cette culture qu’il amplifie. Pas parce qu’il discrimine. Parce qu’il optimise. Et qu’optimiser sur un monde biaisé donne un modèle encore plus biaisé.

Cela en dit long, évidemment, sur la manière dont ces inégalités se perpétuent, voire s’aggravent, silencieusement, même dans un espace présenté comme “professionnel” et “méritocratique”.

La vraie question n’est plus “y a-t-il un biais ?”

La vraie question est maintenant :

Le biais est-il suffisamment significatif pour altérer la visibilité professionnelle d’un groupe entier ?

Et, d’après les données, les expériences, les témoignages et les premières analyses scientifiques, la réponse commence à pencher dangereusement vers le « oui ».

Certes, il reste encore beaucoup à analyser sur le sujet. Mais il serait irresponsable d’ignorer ce faisceau d’indicateurs. Sur ce sujet-là aussi, on pourrait espérer bien davantage du Digital Services Act et de l’IA Act européens…

Xavier Degraux, Consultant et formateur en marketing digital et réseaux sociaux (LinkedIn en tête), augmenté par l’IA et les data