LinkedIn lit beaucoup plus qu’avant, écoute de mieux en mieux, observe un peu… mais il ne “comprend” pas encore vos images, PDF et vidéos comme un modèle multimodal complet. La vraie multimodalité est une capacité disponible chez Microsoft… mais pas encore une pratique ouverte de LinkedIn. Explications.

Depuis plusieurs années, une idée séduisante circule parmi les créateurs de contenu et les professionnels du marketing : “LinkedIn voit tout ».

Le réseau social professionnel analyserait en profondeur les images, lirait l’intégralité des PDF convertis en carrousels, écouterait les vidéos du début à la fin, et comprendrait les contenus visuels publiés bien au-delà des mots-clés proposés dans les légendes.

Cette idée n’a rien de farfelu. LinkedIn appartient à Microsoft, dont les capacités d’analyse multimodale – via Azure AI, Azure AI Content Understanding et les modèles intégrés à Copilot – sont désormais capables de “lire” des documents complexes, d’extraire du sens d’une vidéo, de reconnaître des éléments visuels, de transcrire une voix et de produire des synthèses via des modèles d’IA avancés.

Mais LinkedIn utilise-t-il, pour son propre algorithme, cette puissance multimodale ? Autrement dit : ce qu’il peut faire (techniquement), est-il ce qu’il fait (réellement) dans le feed ?

J’ai mené ma petite enquête, suite à la question d’un participant à ma récente Masterclass LinkedIn. Et voici ce que j’ai découvert.

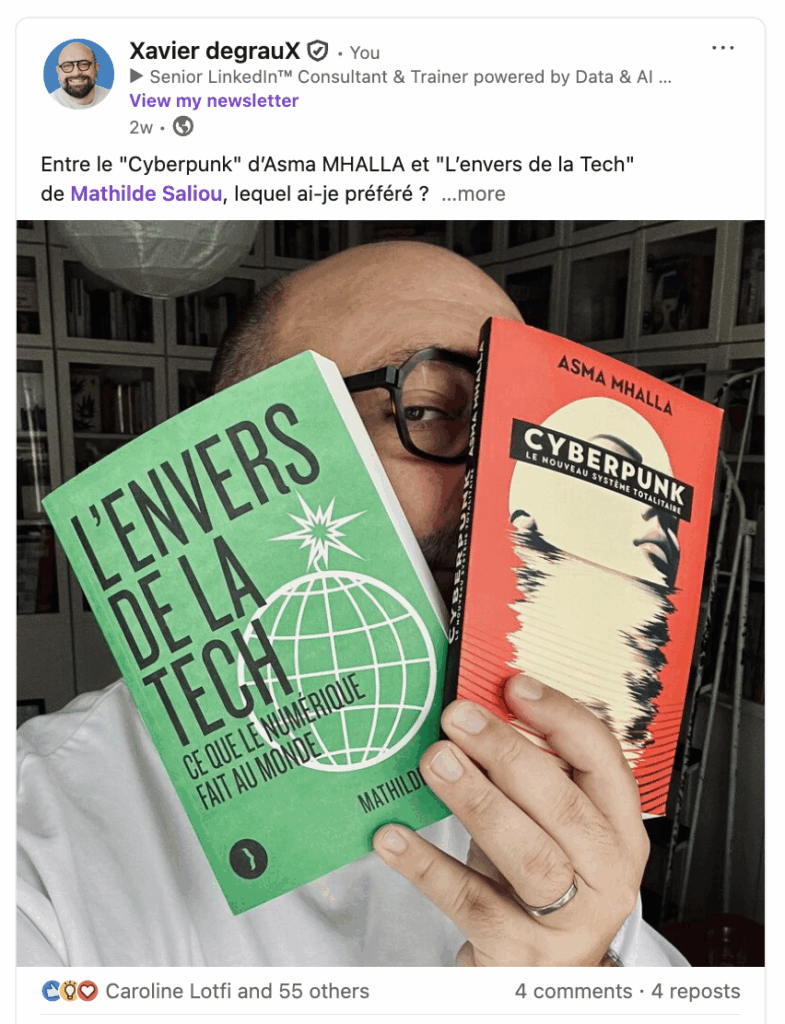

Images : LinkedIn “lit” le texte, pas (encore) les pixels

Parmi les croyances les plus installées, celle-ci arrive en tête : “LinkedIn scanne toutes vos images comme Google.”

Alors, même si on s’en doutait déjà, oui, le format image est un signal algorithmique, que LinkedIn privilégie, comme tous les contenus natifs, Ce que confirment toutes les études marketing et les analyses techniques de ces derniers mois, comme celles de Hootsuite.

Et oui, LinkedIn permet d’ajouter un texte alternatif (alt-text) aux images, destiné aux personnes malvoyantes… ou utilise l’IA pour générer automatiquement une première version de ce texte alternatif, laquelle décrit la scène de manière rudimentaire (ex. : “une personne devant un ordinateur”).

Des analyses récentes de l’accessibilité confirment d’ailleurs que LinkedIn associe correctement ces métadonnées textuelles aux images et les expose aux technologies d’assistance.

LinkedIn “voit”, donc, au sens strict, grâce à un texte associé à l’image, fourni manuellement ou généré par l’IA. Mais cela ne signifie pas qu’il analyse les pixels pour comprendre l’image comme un modèle d’IA multimodal avancé.

Précisons en passant, pour couper les ailes à certains canards, que LinkedIn stocke techniquement le nom des fichiers que l’on mets en ligne, mais que rien ne prouve qu’il s’en serve comme signal de visibilité dans le feed.

L’OCR automatique sur toutes les images ? Techniquement possible, mais non documenté

Allons plus loin. Et c’est là où la confusion est la plus fréquente.

Microsoft, via son service Azure AI Content Understanding, permet de faire de l’OCR sur des images et des documents.

OCR signifie Optical Character Recognition, ou en français Reconnaissance Optique de Caractères.

C’est une technologie qui permet à un ordinateur de détecter et extraire automatiquement du texte présent dans une image, un document scanné ou une vidéo.

L’OCR “regarde” une image et transforme :

- les lettres imprimées,

- les mots,

- les chiffres,

- les titres,

- parfois même les tableaux

…en texte exploitable par une IA ou un logiciel classique.

Par ailleurs, Azure AI Content Understanding permet de :

- détecter objets, visages, éléments visuels

- analyser des vidéos image par image

- structurer des documents hybrides (texte + visuel)

- indexer des corpus multimodaux entiers

- produire des représentations sémantiques avancées

Sauf que LinkedIn, de son côté, n’a jamais indiqué publiquement jusqu’ici qu’il applique l’OCR aux images du feed, qu’il analyse les visuels avec un modèle multimodal, ou qu’il utilise les objets détectés pour booster la visibilité.

Le papier scientifique majeur de LinkedIn sur le moteur de recommandation précise même que le modèle encode les contenus avec du texte uniquement. Rien ne prouve qu’il analyse massivement les pixels des images pour le ranking. Et rien ne prouve qu’il fait du SEO interne sur les textes présents dans les images.

PDF / Carrousels : Le format le plus puissant… mais pas “lu” comme un document complet

Les carrousels LinkedIn (PDF ou PPT convertis en images pour l’affichage) sont devenus un outil central dans les stratégies de contenu. Ils génèrent un engagement qui dépasse souvent le texte, la vidéo, les sondages…

Mais comment LinkedIn les interprète-t-il réellement ?

En accessibilité, les experts déplorent que chaque slide soit traitée comme une image sans ALT individuel. Cela implique clairement :

- une slide de carrousel n’est pas un “document lu”, mais une image affichée

- LinkedIn ne se comporte pas comme un moteur de recherche de documents type Google Drive

Le PDF n’est donc pas récompensé parce qu’il est “compris”, mais parce qu’il retient l’attention, mécaniquement via :

- du temps passé,

- des interactions (swipes),

- des clics en plein écran,

- des arrêts dans le scroll.

Là encore, Azure AI saurait parfaitement :

- extraire tout le texte d’un PDF

- identifier titres, tableaux, colonnes, légendes

- produire une représentation sémantique profonde

Mais LinkedIn n’a jamais documenté l’indexation massive du texte interne des PDFs du feed, leur utilisation dans un moteur de recherche, leur injection dans les modèles de ranking.

LinkedIn “écoute” vos vidéos, mais ne les “comprend” pas encore comme YouTube

Quant à la vidéo, c’est le format où l’imaginaire collectif s’éloigne le plus de la réalité.

Certes, LinkedIn génère automatiquement des sous-titres (“auto captions”). Cela signifie que tout ce que vous dites devient du texte. Et tout texte peut influencer :

- le SEO interne

- la pertinence

- la recommandation (potentiellement)

Certes, LinkedIn utilise l’IA pour repérer contenu nuisible, deepfakes, comportements toxiques. Il serait absurde de ne pas utiliser un minimum de vision machine pour détecter de la nudité, de la violence, du texte offensant dans la vidéo, des images manipulées…

Cependant, contrairement à YouTube ou TikTok, LinkedIn ne publie aucun papier technique démontrant :

- un modèle multimodal audio + visuel + texte pour le feed

- la lecture sémantique image par image

- l’usage d’Azure AI Content Understanding dans le ranking

Et le nouveau moteur de recherche interne encode les contenus… avec du texte uniquement.

LinkedIn analyse vos contenus, mais pas comme on le croit

À ce stade, on peut affirmer que LinkedIn analyse vos images, vidéos et PDF. Mais essentiellement via le texte :

- légendes

- alt-text

- transcriptions

- commentaires

- métadonnées

- comportement utilisateur

Microsoft, via Azure AI Content Understanding, dispose d’un pipeline multimodal complet capable de “lire” images, documents, vidéos et audio.

Mais LinkedIn ne documente pas l’usage de ces capacités pour le feed public.

Les papiers scientifiques officiels montrent un système :

- text-first

- centré sur la pertinence sémantique

- alimenté par le dwell time

Cela dit, la donne pourrait changer…

Sauf si vous avez refermé ce paramètre, vos contenus multimédias sont désormais utilisés pour entraîner les IA de LinkedIn. Mais sans transparence sur comment ils sont analysés.

Xavier Degraux ► Stratège LinkedIn™, Employee Advocacy & Social Selling ► Je transforme Marques, Comex & Dirigeants en Médias (Autorité) ► Thought Leadership Data-Driven & IA ► Ex-Journaliste Éco

Aller plus loin ?

Dans un article publié en juin 2025, “The Complete Mathematical Framework for Future-Adaptive Visual Intelligence”, Mike Sumaquial propose un cadre théorique pour construire des systèmes d’IA visuelle capables de s’améliorer automatiquement au fil des progrès des modèles multimodaux.

L’idée : découper les visuels en “tuiles” pour mieux les analyser, utiliser la mémoire pour accélérer la compréhension, et combiner texte, image et audio pour produire des insights plus riches.

Ce type d’approche montre clairement à quoi pourrait ressembler un LinkedIn “nouvelle génération” vraiment multimodal — même si, aujourd’hui, la plateforme reste surtout centrée sur le texte.