En 2025, les fils des réseaux sociaux sont remplis de textes, d’images et de vidéos générés ou “améliorés” par l’IA. En trois ans, la part de publications issues de proches a reculé au profit de contenus recommandés et prédictifs. Les plateformes testent des outils de limitation et des garde-fous. Mais la confiance vacille…

On l’avait vu venir il y a déjà deux ans... C’est fait ! Les contenus générés par Intelligence Artificielle (IA), remixés par IA ou simplement optimisés par IA pour la rétention dominent désormais les fils des réseaux sociaux. On parle de textes, d’images, de sons et, à présent, de vidéos synthétiques.

La vidéo générée par IA a en effet franchi un cap en 2025, avec des outils capables de produire des plans cohérents avec son et mouvements crédibles à partir de simples prompts.

Google a lancé Veo 3 puis Veo 3.1, capables de sorties verticales 9:16 adaptées au mobile, et une tarification pensée pour l’usage à grande échelle, ce qui favorise la production pour YouTube Shorts, mais aussi Instagram (Reels) et TikTok.

Face à Midjourney, sa bête noire, OpenAI a présenté Sora 2, qui améliore la consistance visuelle et l’édition de scènes, accélérant la fabrication de clips plausibles.

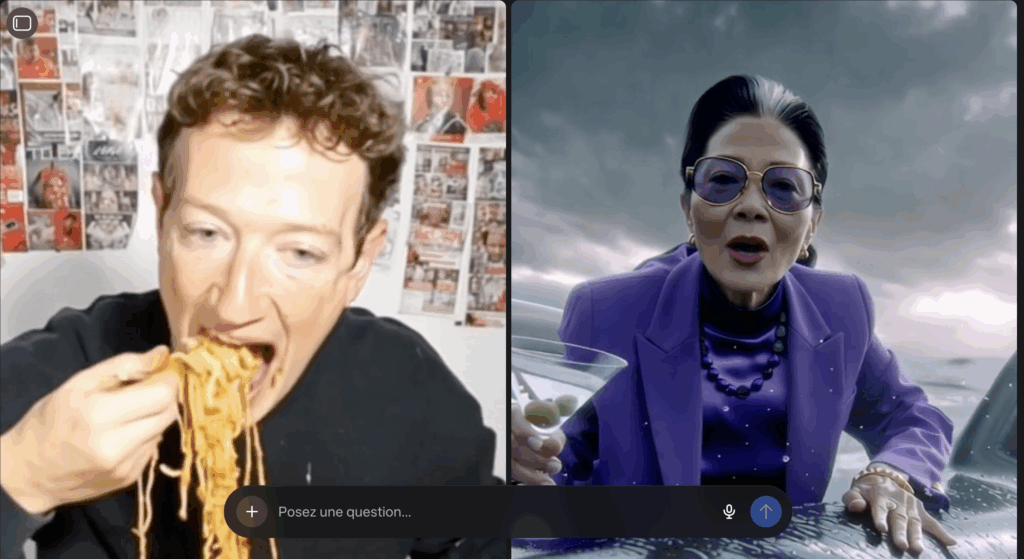

Meta (Instagram, Facebook…) a lancé Vibes, y compris en Europe : un nouveau type de réseau social, un flux court composé de vidéos générées par IA au sein de l’app Meta AI, qui illustre, comme Sora 2, la massification du « prêt-à-scroller » synthétique.

Sur TikTok, les fonctions de création génératives intégrées au compositeur, du texte-vers-vidéo aux transitions, banalisent la production in-app.

La norme du « AI slop »

L’abaissement des coûts de production de contenus de plus en plus « personnalisés fait entrer les réseaux dans une ère d’hyperproduction. Le marketing a popularisé la notion d’« AI slop » pour désigner ce déluge de contenus à faible valeur ajoutée, souvent convenus et grotesques, qui saturent les fils et homogénéisent l’esthétique.

Cette production à la chaîne crée un bruit de fond qui capte des impressions sans valeur éditoriale, au risque d’“enshitifier” l’expérience sociale.

Les chiffres clés de l’IA Slop sur les réseaux sociaux sont éloquents :

- En juillet, près d’1 chaîne à très forte croissance sur 10 sur YouTube publiait exclusivement des vidéos générées par IA, avec des cas emblématiques comme Super Cat League à 3,9 millions d’abonnés.

- Des contenus IA à très faible effort atteignent aussi des millions de vues sur Instagram

- Sur LinkedIn, plus de 54% des posts longs en anglais seraient probablement rédigés par IA, ce qui homogénéise le ton et le format

Brouillage de l’origine : C2PA progresse, l’expérience reste inégale

L’ « AI slop » n’est pas seulement irritant. Couplée aux bots et aux deepfakes, elle fragilise la confiance et peut produire des effets réels.

Des images synthétiques crédibles peuvent faire basculer la perception d’un événement en quelques minutes, avant d’être démenties. Trop tard ! (Loi de Brandolini)

Pire : les boucles de rétroaction où des modèles apprennent sur des données déjà polluées par l’IA accentuent encore le risque de “model collapse” et d’“AI-bias”, c’est-à-dire la préférence des systèmes pour des textes générés au détriment de signaux humains et le renforcement des biais pré-existants, comme sur LinkedIn par rapport aux femmes.

Provenance vérifiable: du standard C2PA au passeport d’IA

Pour filtrer le bruit, deux couches techniques émergent tout doucement.

- Le standard C2PA et les Content Credentials permettent d’attacher des métadonnées vérifiables à une image, une vidéo ou un audio, retraçant capture, montage et génération.

- Un AI Service Passport (AISP) regroupe des justificatifs signés sur un modèle ou un service : identité de l’éditeur, notes sur les données d’entraînement, résultats de TEVV (Test and Evaluation, Verification and Validation), certifications, usage prévu… Présenté comme une étiquette nutritionnelle, il permet d’évaluer la fiabilité d’un modèle avant d’en consommer les sorties et de l’auditer a posteriori.

Malheureusement, dans la pratique sociale, deux fragilités persistent.

D’abord, les métadonnées peuvent être perdues à l’upload, au transcodage ou lors d’un repost multi-app.

Ensuite, quand elles survivent, le label n’est pas toujours visible au bon endroit de l’interface.

C’est pas gagné…

À l’automne 2025, un test du Washington Post a d’ailleurs publié la même vidéo deepfake, marquée avec des Content Credentials, sur huit apps sociales. Une seule a affiché un avertissement, et il était peu saillant.

Ce que font les plateformes aujourd’hui

Plusieurs acteurs affirment renforcer la transparence, avec des résultats inégaux selon les interfaces et les formats.

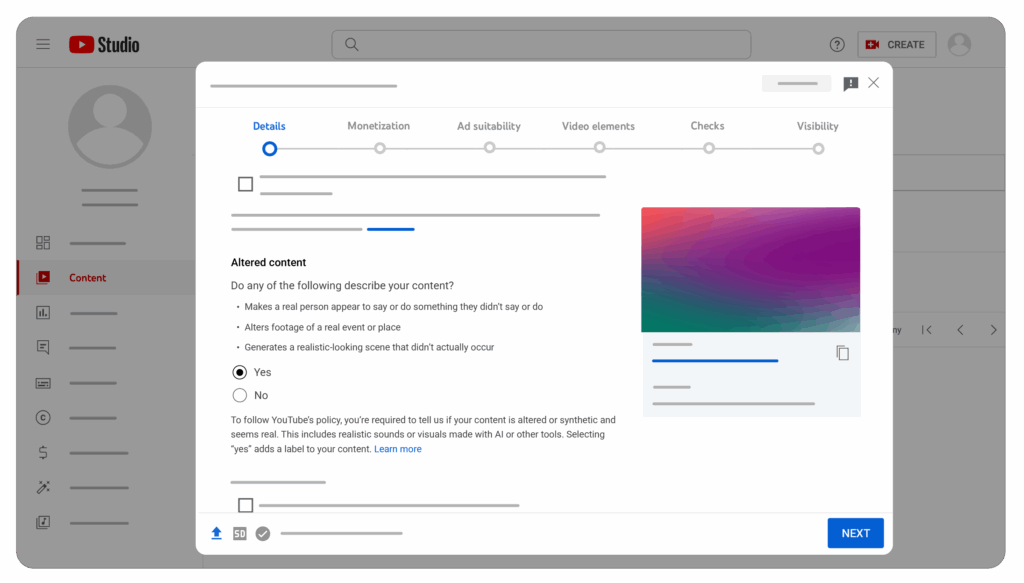

- YouTube intègre Veo 3 Fast dans Shorts pour générer des clips avec son, et teste des fonctionnalités comme « Edit with AI » et « Speech to Song ». La plateforme exige par ailleurs la déclaration des contenus réalistes altérés ou synthétiques, avec un avertissement côté spectateur, et applique le filigrane SynthID et des labels IA. Tout en testant de nouvelles options de contrôle du feed (« Your custom feed »).

- Meta, qui semble tourner la page du Metavers, marque les images “Made with AI” sur Facebook, Instagram et Threads… quand des indicateurs industriels sont présents.

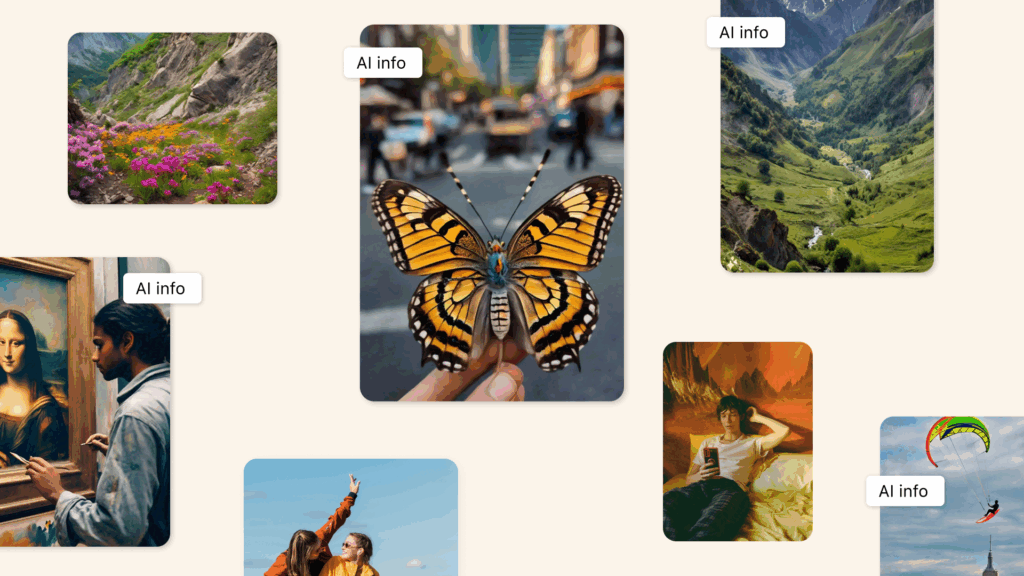

- Pinterest propose des réglages pour réduire la part d’images IA dans certains flux thématiques, symptôme d’une demande d’authenticité pilotée par l’interface.

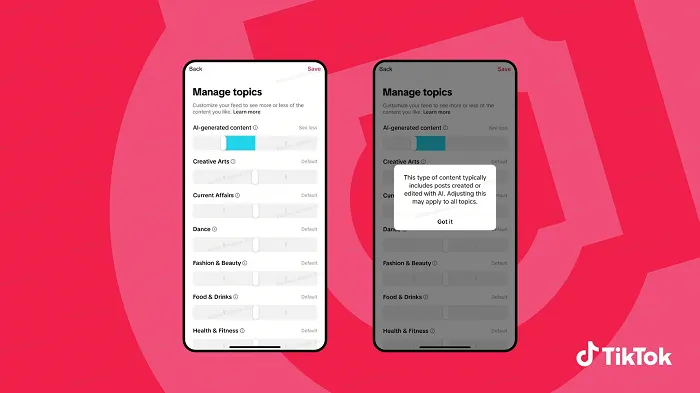

- TikTok ajoute des outils de création générative dans le compositeur et appose automatiquement une mention “AI-generated” à l’import quand des Content Credentials normalisés sont détectés… tout en lançant, comme Pinterest, un nouvel outil pour réduire la part de vidéos générées par IA dans son fil.

À l’inverse des géants du secteur, des plateformes comme Threads ont une saturation moindre en IA grâce à une modération plus stricte et un public davantage tourné vers des échanges organiques et authentiques… par rapport à X (ex-Twitter), que Threads a cloné.

La désormais filiale de xAI, le groupe d’Elon Musk, reste intermédiaire, avec une audience large mais une modération parfois moins rigoureuse, ce qui entraîne une saturation modérée en contenus IA.

En fait, c’est Bluesky, plus communautaire et centré sur une modération avancée, qui montre le plus faible taux de saturation en IA comparé.

Le paysage est donc encore « AItérogène » (vous l’avez ?), même en Europe, où la Commission a lancé un code de bonnes pratiques pour le marquage et l’étiquetage des contenus générés par IA, afin d’accompagner l’AI Act. Mais pour combien de temps ?

Ce que les professionnels peuvent faire

Une dizaine de chantiers prioritaires pour réduire le bruit, renforcer la traçabilité et réorienter l’attention vers des contenus identifiés, utiles et crédibles, dans des fils où l’IA est devenue la norme, peuvent intéresser les pros.

- Fixer la règle du jeu IA

- Politique écrite: ce qui est autorisé, déclaré, proscrit…

- Mention explicite dans la légende quand l’IA a un rôle substantiel

- Liste blanche des outils et des usages acceptés

- Protéger la provenance de bout en bout

- Activer C2PA et Content Credentials sur toutes les créations

- Vérifier la conservation des métadonnées après upload et repost multi-apps

- Prévoir un libellé visible au premier écran sur chaque réseau

- Construire un « passeport » de vos modèles

- Tenir un mini AI Service Passport par outil : éditeur, données, résultats TEVV, limites…

- Archiver ce passeport avec les assets publiés pour auditer a posteriori

- Produire moins, signer mieux

- 2 ou 3 formats signature qui résistent à l’homogénéisation des fils

- Mixer captation authentique et éléments génératifs déclarés

- Interdire les stocks IA génériques qui diluent la marque

- Rendre les labels lisibles là où l’on regarde

- Maquettes mobiles avec label IA

- Vignettes, titres, descriptions qui reprennent la mention IA en clair

- Anticiper les pics de risque

- Actualité, politique, santé : double validation éditoriale et preuve d’origine obligatoire

- Playbook deepfake : vérifs, réponse, correctif public en 3 étapes…

- Assainir la diffusion payante

- Ads génératives seulement avec disclosure visible et variantes testées

- Contrat de provenance avec agences et créateurs

- Couper l’achat sur inventaires saturés d’AI slop ?

- Organiser la modération pour l’IA

- File dédiée provenance IA, délais cibles et critères de dépriorisation

- Outils de notes collaboratives et liens vers sources primaires

- Agents et chatbots sous identité vérifiable et délégation PoA, sinon blocage

- Mesurer ce qui compte vraiment

- Ajouter des KPI IA: part de contenus labellisés vus, taux de rétention C2PA, watch time et completion IA vs non-IA, temps médian de modération, taux de rectification publique…

- Former et outiller les équipes

- Sensibilisation aux signaux de contenus synthétiques et à la lecture des credentials

- Check-lists tournage édition IA, diffusion, gestion de crise

- Veille continue sur politiques YouTube, TikTok, Meta et évolutions C2PA, TEVV…

À retenir

- Les fils sociaux sont désormais dominés par des contenus générés ou optimisés par IA, ce qui réduit la part de posts authentiques et fragilise la confiance.

- L’« AI slop » s’impose: une hyperproduction low cost qui homogénéise les formats, surcharge les fils et dégrade l’expérience.

- Malgré C2PA et les Content Credentials, la traçabilité reste inégale, tandis que les risques de deepfakes, biais et « model collapse » augmentent.

- Les plateformes ne sont pas toutes touchées au même niveau: les fils prédictifs sont saturés, alors que des espaces comme Bluesky restent moins pollués.

Xavier Degraux ► Stratège LinkedIn™, Employee Advocacy & Social Selling ► Je transforme Marques, Comex & Dirigeants en Médias (Autorité) ► Thought Leadership Data-Driven & IA ► Ex-Journaliste Éco

Découvrez les 7 tendances sur les réseaux sociaux en 2025-2026

- Introduction : Les 7 tendances des réseaux sociaux en 2025-2026

- Les réseaux sociaux ne sont plus vraiment sociaux (1/7)

- Passive scrolling et bascule des conversations en privé (2/7)

- Des fils saturés d’IA et de contenus ultra-transformés (3/7)

- Quand les réseaux sociaux deviennent assistants IA et moteurs de recherche (4/7)

- La vidéo courte règne, mais la longue convertit (5/7)

- Portée organique en chute: place au pay-to-play pour tous ? (6/7)

- Réseaux sociaux: la confiance s’érode encore (7/7)

- Conclusion : Les 7 tendances des réseaux sociaux en 2025-2026 (synthèse exécutive)