– Article mis à jour le 24 octobre 2025 –

Les études sur l’algorithme de LinkedIn se multiplient. Faut-il leur faire confiance ? Analyse critique de leurs (belles) promesses, de leurs biais et de leurs limites, à l’heure où l’arrivée de 360Brew, le système dopé à l’IA, rebat sérieusement les cartes.

De plus en plus de rapports, que je relaie parfois sur mon site et via mon profil, promettent de percer les secrets de l’algorithme de LinkedIn. Y compris ceux du tout récent 360Brew.

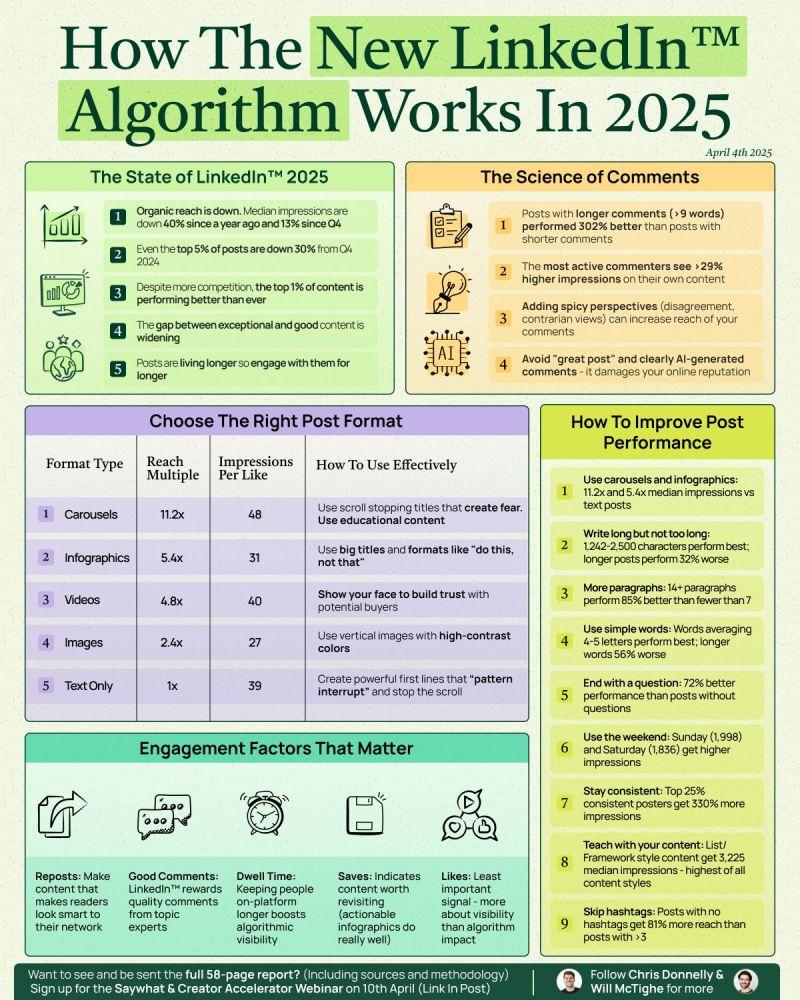

À travers des analyses de milliers de posts, voire de millions, ces études nous expliquent quels sont les meilleurs formats LinkedIn, les heures idéales pour poster, les types de posts à privilégier ou à éviter…

Certaines sont publiées par des outils comme SocialInsider, Metricool, Hootsuite, PerfectPost, MagicPost ou encore SayWhat.

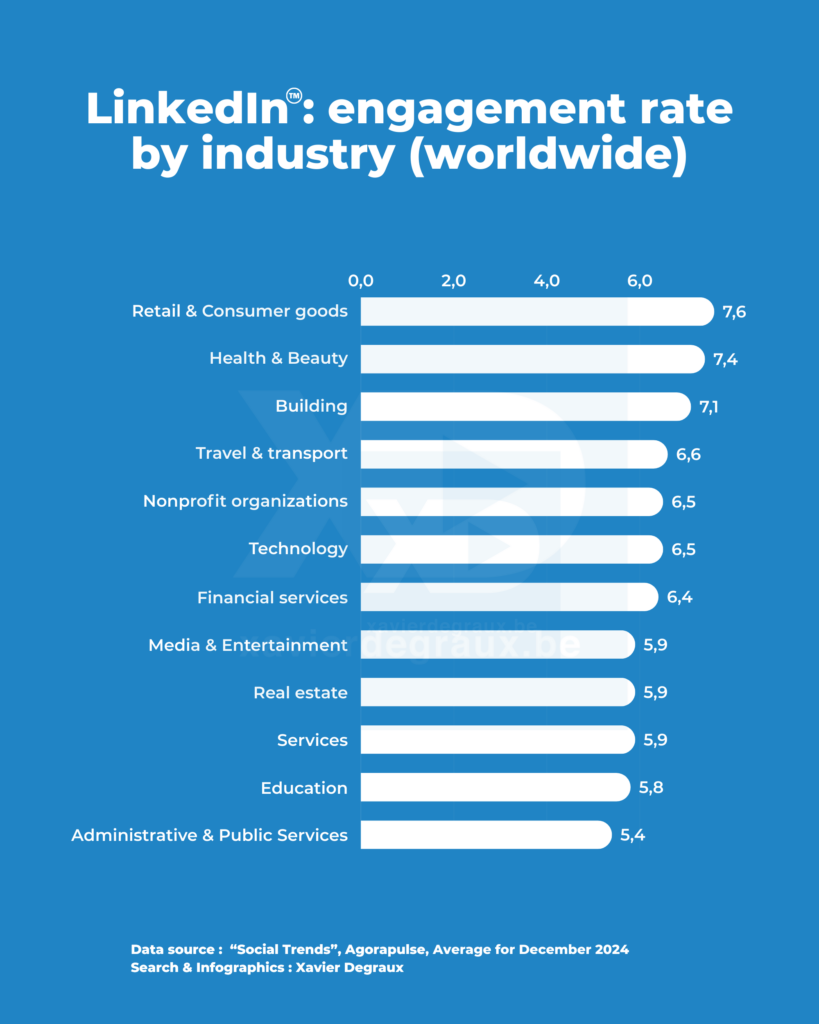

D’autres par des individus comme mon ancien collègue au sein du Just Connecting Hub Richard van der Blom, comme Chris Donelly et Will McTighe, ou comme moi (voici celle que je réalise régulièrement avec l’outil d’Agorapulse, mais sans collaboration commerciale, je tiens à le préciser).

Ces études sur l’algorithme LinkedIn sont souvent bien intentionnées, parfois utiles, mais presque toujours présentées comme des vérités, générales et définitives.

Or, dans les faits, elles méritent d’être nuancées, car elles comportent de sérieuses limites, que les auteurs ne prennent pas toujours la peine de préciser.

C’est exactement ce que je vous propose dans cet article : une petite analyse critique de ces études.

Des méthodologies rarement transparentes

Commençons par la base. Nombre de ces études ne précisent pas la composition de leur échantillon. S’agit-il de profils individuels (moins de 4% des membres de LinkedIn publient) ou de pages d’entreprises (et dans quelles proportions) ? De personnes lambda (rarement), ou de créateurs de contenu ? Comment ont-ils été sélectionnés ? Dans quels secteurs, pays, langues ? Les auteurs de ces études ont-ils accès aux statistiques « internes » (anonymisées via LinkedIn ou obtenues par les propriétaires des comptes) ou uniquement à des données publiques ?

L’étude que je mène, par exemple, est basée sur les seuls utilisateurs payants d’Agorapulse, ce qui est évidemment un énorme biais. D’autant que, limité par l’outil, je ne peux pas prendre pas en compte la taille des comptes étudiés.

Le rapport de Metricool, lui, repose sur « 577.180 publications issues de 47.735 pages LinkedIn », classées par taille de compte (moins de 1.000 followers, entre 1.000 et 10.000, etc.). Une granularité appréciable, certes, mais qui ne porte, là encore, que sur des pages administrées depuis l’outil payant.

L’étude 2025 de Richard van der Blom, quant à elle, s’appuie sur « 1,8 million de posts », selon les teasers. Mais leur origine (utilisateurs d’AuthoredUp ?) et leur ventilation ne sont pas divulguées… alors que les performances de profils et des pages sont, elles, différenciées. Tout comme les formats de publication étudiés. Un absence de transparence à prendre ou à laisser, apparemment.

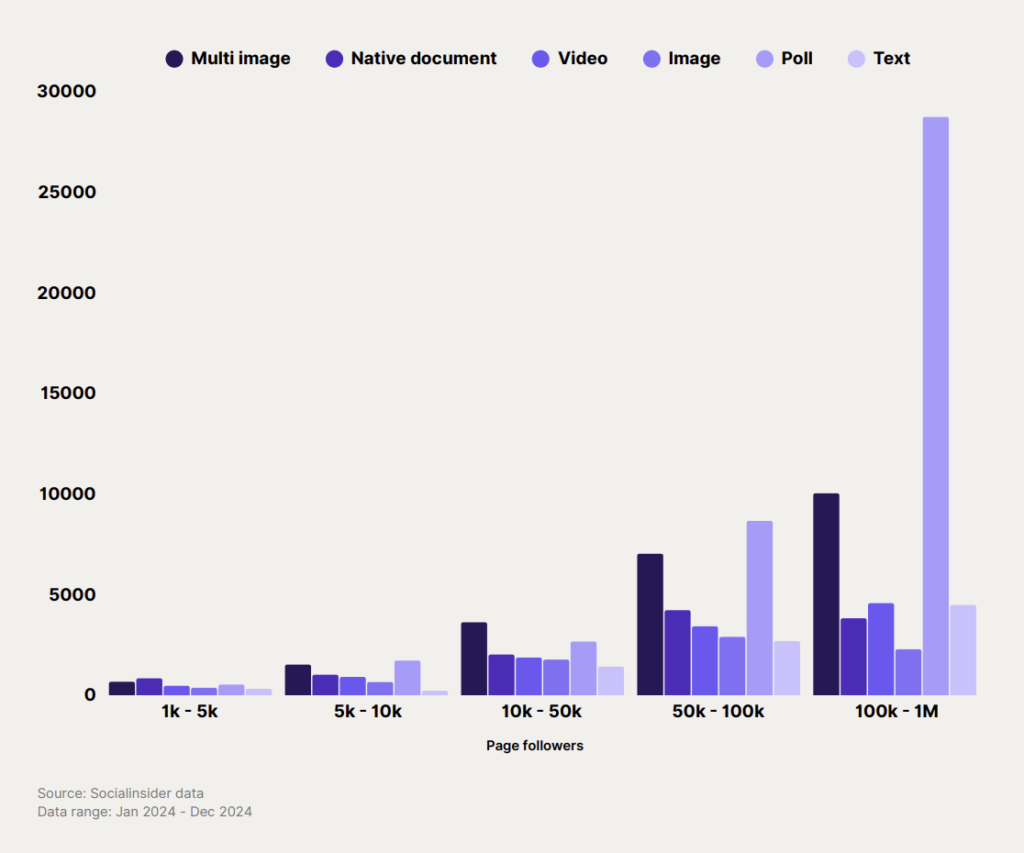

Celle de SocialInsider porte sur les publications de 9.000 pages, soit environ 0.00006% du total des pages LinkedIn. Et la représentativité de son échantillon ? Mystère.

Et de son côté, l’étude SayWhat x Creator Accelerator ne détaille pas non plus le profil des comptes analysés, si ce n’est qu’ils sont créateurs “actifs”, ce qui introduit également un biais structurel.

Idem du côté de Perfect Post, graphique révélateur en prime ;-).

Bref, dans 100% des cas, les échantillons sont limités et leur représentativité peut être mise en doute, ce qui biaise évidemment les conclusions que l’on peut tirer de leurs études.

Cela explique d’ailleurs en grande partie la variété des conclusions de ces études. Voire leurs contradictions, par exemple sur le niveau de baisse de la portée, de l’engagement (ou son maintien), du rythme de croissance des abonnés, des performances des différents formats, des meilleures heures de publication, etc. Voire pire, leurs zones d’ombre…

Corrélation n’est pas causalité

L’autre biais le plus fréquent dans ces études consiste à déduire des règles à partir de corrélations statistiques.

Par exemple, lorsque PerfectPost indique « + ton nombre d’abonnés augmente + tes impressions suivent », c’est confondre corrélation et causalité (et se vautrer dans les vanity metrics au passage).

Autre exemple : Metricool souligne que les carrousels PDF sont les contenus qui génèrent le plus d’engagement, avec un volume élevé de clics. OK. Mais est-ce parce que le format est intrinsèquement performant… ou parce que ceux qui l’utilisent déjà sont expérimentés, bien suivis et publient du contenu de qualité ? Et/ou, autre possibilité, parce que ces posts créent des effets qui, eux sont favorisés par l’algorithme (dwell time, taux de commentaires riches…) ?

Même problème avec les sondages, qui bénéficient d’une portée moyenne « 206% supérieure aux autres formats ». Or, leur fréquence d’utilisation reste infime (0,00034 % des posts), toujours selon Metricool — ce qui pourrait suggérer que cette performance tient autant à leur rareté qu’à leur efficacité.

Et quand Richard van der Blom affirme pour le format « texte + image seule » que « les légendes de 400 mots et plus peuvent générer plus de 2X plus d’engagement si elles sont structurées et faciles à digérer », soyons direct, c’est surtout la subjectivité de l’auteur qui est mesurée…

Et avec 360Brew, cette nuance devient encore plus cruciale. L’algorithme évalue désormais la cohérence entre votre profil, votre niche et la pertinence de vos interactions. Un post peut “cartonner” non pas parce qu’il suit une règle (longueur, structure, horaire…), mais parce qu’il résonne sémantiquement avec le réseau qui le lit. En clair : la cause profonde du succès devient moins visible, plus contextuelle, et donc plus difficile à modéliser.

Des instantanés dans un environnement mouvant

LinkedIn ajuste sans cesse son algorithme, le plus souvent sans communication officielle. Du coup, en quelques mois, la visibilité des événements, la priorité donnée aux vidéos ou la mise en avant des newsletters par exemple peuvent changer. Drastiquement.

Assurer, comme certains, que l’anatomie d’un post hautement performant définie grâce à telle ou telle étude permet de savoir « ce qui fonctionne vraiment pour le moment » relève davantage du storytelling commercial que de la rigueur scientifique.

Pour le dire platement, ces études sont des photos du passé. Et la photo n’est pas contractuelle 😉

L’obsession de l’engagement visible

L’engagement, souvent placé au au coeur de ces études, est souvent défini comme la somme des likes, commentaires et partages. Mais qu’en est-il :

- des clics ?

- des envois en message privé ?

- des sauvegardes ?

- du « dwell time » (durée de consoimmation d’un post et de ses commentaires) ?

Aucune étude ne mesure ces interactions invisibles (« dark social »), alors qu’elles sont plus que probablement décisives dans l’algorithme, comme LinkedIn l’a d’ailleurs lui-même indiqué.

Et qu’en est-il de l’impact du contexte d’une publication ? Mon plus gros « hit » a été diffusé un dimanche soir à presque 23h, parce qu’au-delà de la qualité évidente de mon post (;-)), le contexte informationnel y était extrêmement favorable.

Dans ces études, tout cela n’est pas révélé, pas même mentionné…

En revanche, certaines sont, disons, très « créatives ».

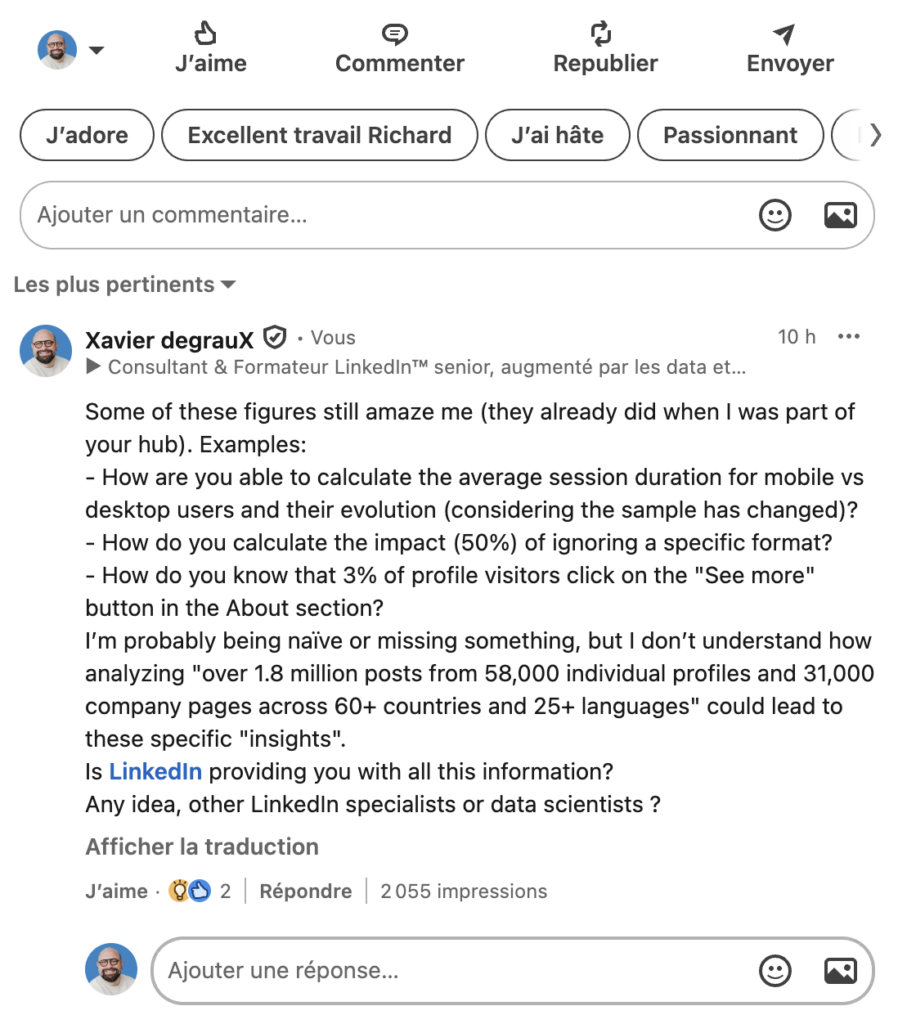

Malgré mes 20+ années d’expérience de LinkedIn, j’ignore toujours comment on peut mesurer, de l’extérieur, la vitesse à laquelle LinkedIn scelle le sort de votre contenu une fois publié, l’évolution du temps moyen des sessions mobiles (sur des échantillons différents chaque année, qui plus est), l’impact des posts et commentaires générés au moins pertiellement par AI, le poids exact de chaque type d’interaction dans l’algo…

« Secret sauce », répondent en substance les auteurs de ces rapports, à qui LinkedIn demande très fermement d’en être explicitement dissociés.

Le caractère performatif des recommandations

Autre limite… Quand une étude affirme que “le mardi à 9h” est le meilleur moment pour publier, l’effet est immédiat : les lectrices et lecteurs de l’étude ont évidemment tendance à publier au même moment.

Résultat ? La concurrence augmente, la visibilité baisse, et l’algorithme adapte ses signaux en conséquence.

Pareil quand, à force de répéter que “les carrousels fonctionnent”, “les hooks doivent poser une question”, “les posts doivent faire 3 lignes + 3 bullets + une question finale”… Les publications LinkedIn finissent par toutes se ressembler… et à devenir moins efficaces.

C’est l’un des effets pervers : certains conseils massivement suivis finissent par produire l’effet inverse de celui escompté (effet miroir). Et avec 360Brew, cette homogénéisation devient un vrai frein.

Des moyennes peu exploitables

Bien qu’intéressantes quand on les lit pour ce qu’elles sont, donc avec un regard critique, ces études sont rarement exploitables directement.

La plupart des chiffres avancés sont des moyennes de moyennes de moyennes.

Exemple : Metricool indique que les sondages ont un taux d’engagement moyen élevé… mais ne précise pas leur performance dans des secteurs spécifiques, auprès de cibles professionnelles différentes, ou avec des objectifs distincts (notoriété, recrutement, génération de leads…), dans des cultures différentes.

Et quand c’est le cas, comme dans mon étude avec Agorapulse, c’est toujours une granularité insuffisante, presque par définition.

C’est aussi le cas pour les heures ou les jours de publication. Dire que “le mercredi est le jour avec le plus d’interactions” ne signifie rien si votre audience est constituée de cadres du secteur de la santé qui se connectent surtout le week-end.

Le meilleur “moyen” reste celui que vous mesurez vous-même.

Les études sur l’algorithme ne captent pas la réalité des micro-communautés ni des stratégies discrètes mais efficaces. Pire : elles les invisibilisent.

Entre outil d’observation et mirage collectif

Bref, aucune étude, aussi massive soit-elle, ne pourra vous dire :

- Ce qui fait sens pour votre audience cible

- Ce qui reflète le mieux votre positionnement

- Comment parler de vos enjeux, dans votre culture, avec vos contraintes

- Ni comment ajuster vos contenus à vos résultats réels (impressions, taux de clics, messages privés, qualité des interactions…)

Seule une stratégie adaptée, fondée sur vos propres tests, vos propres données et vos propres objectifs, peut répondre à ces questions.

Les études sur l’algorithme LinkedIn sont utiles — à condition de savoir ce qu’on en attend.

Elles peuvent inspirer, donner des repères, offrir des comparaisons. Mais elles ne remplacent ni l’analyse de vos propres performances, ni une stratégie éditoriale pensée sur mesure.

Lire avec attention, tester avec méthode, observer les signaux faibles, et itérer avec bon sens : c’est tout sauf magique, mais c’est la voie la plus solide sur LinkedIn.

Xavier Degraux

P.S. : Je ne résiste pas à épingler, via cette capture d’écran, le commentaire d’un grand sage : celui de Kevin D. Turner, qui est pour moins l’un des meilleurs connaisseurs de LinkedIn au monde (il a cartographié et documenté au moins 19 algos Linkedin), et avec qui j’ai le plaisir d’échanger régulièrement (suivez-le !).